Les points abordés dans ce module :

- Les risques liés à la sécurité informatique

- Les risques liés à l’éthique

- Les enjeux de souveraineté numérique

- Les enjeux environementaux

- Les risques humains

- Les risques informationnels

🟥Introduction : comprendre les risques liés à l’IA

Le titre de ce module est sans équivoque : l’IA est un outil technologique remarquable à bien des égards, et ne pas l’utiliser, la rejeter de but en blanc ou ignorer son existence constituerait une erreur stratégique dans de nombreux domaines, parmi lesquels la cybersécurité. En effet, utiliser l’IA, en connaître les capacités comme les limites, permet de mieux en évaluer les risques. L’IA générative demeure une technologie jeune, aussi bien dans son développement que dans ses usages, et l’objectif de ce module est de l’intégrer avec le plus de sécurité possible, sans non plus tomber dans un enthousiasme aveugle.

Pour présenter les risques liés à son utilisation, nous les avons catégorisés en sept parties : ceux liés à la sécurité informatique, à l’éthique, les enjeux de souveraineté numérique et environnementaux, les risques humains, les risques informationnels et les risques relatifs à la vie privée.

À noter que nous avons pris le parti de ne développer que les risques liés à l’utilisation de l’IA générative. D’autres risques cyber existent, mais ils concernent davantage la sécurité des systèmes d’information dans leur ensemble ou relèvent d’enjeux techniques propres aux développeurs, administrateurs systèmes et réseaux, ou encore aux fournisseurs d’IA. Ces aspects, bien que déterminants pour la robustesse et la fiabilité des solutions, dépassent le cadre de l’utilisateur final et n’ont donc pas été abordés ici.

1. Les risques liés à la sécurité informatique

🕳️La fuite ou le vol d’informations

Premier risque majeur et souvent sous-estimé : il ne faut jamais saisir de données confidentielles ou sensibles dans une IA générative dont on ne maîtrise pas les conditions de sécurité. Cette règle, qui peut paraître évidente, est pourtant régulièrement transgressée, parfois par simple méconnaissance des mécanismes sous-jacents.

Les informations que l’on fournit peuvent être stockées, analysées ou réutilisées selon les politiques ou paramètres activés par l’opérateur ou l’utilisateur. Concrètement, cela signifie qu’une donnée personnelle, stratégique ou confidentielle pourrait être exposée à des risques de fuite, de vol ou d’accès non autorisé, que ce soit à cause d’une faille technique, d’une cyberattaque ou d’une simple erreur de manipulation.

L’Agence Nationale de la Sécurité des Systèmes d’Information (ANSSI) insiste particulièrement sur ce point : le danger ne concerne pas seulement les données utilisées pour entraîner le modèle en amont, mais également toutes celles qui sont saisies lors de son utilisation quotidienne. Par exemple, si un utilisateur copie-colle un extrait de document confidentiel dans une IA générative pour le reformuler ou le résumer, il perd immédiatement le contrôle sur la diffusion de cette information. Celle-ci pourrait être exploitée par des personnes malveillantes, revendue à des tiers, ou même ressortir dans d’autres interactions avec d’autres utilisateurs.

Un cas d’école illustre parfaitement ce risque : en 2023, des ingénieurs de Samsung ont déposé des extraits de brevets confidentiels de l’entreprise dans ChatGPT pour travailler dessus. L’IA s’est alors entraînée avec ces nouvelles informations. Résultat : en interrogeant l’outil sur des éléments précis concernant Samsung et ses produits, la solution répondait en s’appuyant sur le contenu des brevets, révélant ainsi des informations stratégiques qui auraient dû rester secrètes. Cet incident a conduit Samsung à interdire l’usage de ChatGPT en interne et à sensibiliser massivement ses employés aux risques de fuite de données.

Nous verrons dans les prochaines sections comment formuler des requêtes efficaces tout en évitant de divulguer trop d’informations sensibles à l’IA générative.

🧪L’empoisonnement du modèle d’IA

Au-delà de la fuite involontaire d’informations, il existe des attaques beaucoup plus insidieuses visant directement l’intégrité du modèle d’IA. L’empoisonnement consiste à injecter volontairement des données malveillantes ou biaisées dans le processus d’apprentissage d’un modèle d’IA, ou lors de ses mises à jour ultérieures. L’objectif est de modifier subtilement son comportement pour qu’il produise des réponses incorrectes, dangereuses ou manipulées, sans que cela soit immédiatement détectable.

Dans le contexte des IA génératives, comme celles qui créent du texte, des images ou du code, cet empoisonnement peut se traduire par plusieurs scénarios préoccupants :

- Des réponses qui favorisent systématiquement une idéologie particulière, une marque commerciale ou un point de vue politique,

- La génération de contenus trompeurs, offensifs ou discriminatoires dissimulés sous une apparence neutre,

- L’insertion d’instructions dangereuses ou malveillantes dans des prompts apparemment anodins,

- La modification progressive des recommandations pour orienter les décisions des utilisateurs.

À cela s’ajoute la manipulation qui vise à contourner les garde-fous censés empêcher les IA de révéler des informations confidentielles ou de réaliser des tâches proscrites. Pour corrompre le LLM, les hackers jouent sur des techniques dites de « jailbreaking ». Le jailbreaking consiste à tromper la machine pour qu’elle enfreigne ses propres règles : par des reformulations rusées, des scénarios de rôle-play, ou des prompts complexes, les attaquants amènent progressivement l’IA à ignorer ses filtres éthiques et sécuritaires. L’objectif ? Obtenir des réponses normalement bloquées ou interdites, en exploitant la tendance de la machine à coopérer et à suivre les instructions.

Vous pouvez tester l’efficacité de vos propres stratégies et constater à quel point il est possible de manipuler une IA générative, mais aussi observer comment le domaine renforce sa sécurité au fil du temps grâce à ce jeu interactif à plusieurs niveaux.

L’empoisonnement de l’IA est un type d’attaque particulièrement difficile à détecter car elle ne produit pas nécessairement d’erreurs visibles immédiatement. Le modèle continue de fonctionner normalement, mais son comportement est subtilement altéré. Les conséquences peuvent s’avérer graves, surtout dans des domaines sensibles comme la santé, où une IA pourrait recommander un traitement inapproprié, la cybersécurité, où elle pourrait suggérer des configurations vulnérables, ou la justice, où elle pourrait biaiser l’analyse de dossiers.

C’est pourquoi il demeure toujours essentiel de vérifier systématiquement le contenu produit par l’IA et d’éviter autant que possible les systèmes entièrement automatisés dans les processus critiques. Si les garde-fous informatiques existent, la validation humaine reste le meilleur rempart contre ce type de manipulation.

2. Les risques liés à l’éthique

Les biais constituent l’un des enjeux éthiques les plus préoccupants de l’IA générative. Ils apparaissent lorsque les données utilisées pour entraîner une IA ne sont pas représentatives de la diversité réelle ou contiennent des préjugés, conscients ou non. L’IA peut alors reproduire, voire amplifier ces biais, ce qui conduit à des résultats injustes, discriminatoires ou non équitables.

👨⚕️Le cas de la génération d’images biaisées

Pour bien comprendre ce qu’est un biais, prenons une expérience simple que vous pouvez reproduire. Demandez à une IA générative d’images : “generate an image of a doctor in a hospital”. J’ai personnellement fait le choix de formuler cette requête en anglais pour utiliser le terme neutre “doctor”, qui ne spécifie pas le genre. Voici deux propositions que j’ai obtenues avec Sora :

Vous ne trouvez pas quelque chose d’étrange ? En effet, les deux images sont quasiment identiques : dans les deux cas, le médecin est un homme blanc, d’âge moyen, portant une blouse blanche dans un environnement hospitalier aseptisé.

📑Les résultats d’une étude scientifique à ce sujet

Cette observation n’est pas anecdotique. Une étude scientifique publiée en août 2024 a analysé systématiquement les biais démographiques dans les images de médecins générées par des IA. En comparant 1 000 images issues de cinq plateformes différentes avec les données réelles des médecins américains, les chercheurs ont constaté une surreprésentation flagrante des hommes blancs et une sous-représentation significative des femmes, des personnes asiatiques et des Latinos. Ces biais, présents dans toutes les plateformes testées sans exception, posent un risque majeur de renforcement des stéréotypes et de dévalorisation des efforts de diversité dans le secteur de la santé.

L’étude souligne l’importance cruciale de revoir les algorithmes et les données d’entraînement pour garantir une représentation plus fidèle et inclusive de la réalité. Elle appelle également à une prise de conscience collective des développeurs et utilisateurs d’IA sur les enjeux de diversité dans les contenus générés. Car ces biais ne restent pas confinés aux images : ils influencent aussi les textes, les recommandations, les décisions automatisées, et façonnent insidieusement notre perception du monde.

📲Les risques informationels

Outre ces biais, les risques éthiques tiennent aussi aux usages de ces générateurs d’images, et les progrès technologiques d’outils comme Nano Banana Pro peuvent être à double tranchant. Ce dernier générateur d’images IA conçu par Google impressionne par son réalisme, mais aussi par la permissivité de ses garde-fous. NewsGuard, qui évalue la fiabilité des sites d’information, a étudié la capacité de cet outil à participer à des campagnes de désinformation. Les résultats montrent que Nano Banana Pro contribue à la prolifération de fake news plus vraies que natures.

Ce risque informationnel n’est toutefois pas le seul en jeu, d’autres dimensions seront abordées dans la suite de ce module.

3. Les enjeux de souveraineté numérique

Contrairement à ce que l’on pourrait croire, une IA générative n’est jamais neutre. Son comportement, ses réponses, ses valeurs même, dépendent des choix effectués par l’entreprise qui la développe : quelles données sont utilisées pour l’entraînement ? Quelles règles sont appliquées pour filtrer ou modérer les contenus ? Quelles valeurs sont intégrées dans ses algorithmes ? Elle dépend également de la culture et du cadre réglementaire du pays d’origine. Par exemple, la sensibilité à la liberté d’expression, à la protection de la vie privée ou à la promotion de la diversité varie considérablement d’une région à l’autre.

Derrière les solutions d’IA, une question fondamentale se pose : qui contrôle réellement la technologie et les informations que nous utilisons au quotidien ? La souveraineté en matière d’IA désigne la capacité d’un pays, d’une organisation ou d’une entreprise à maîtriser ses propres outils numériques, à protéger ses données stratégiques et à garantir son indépendance face aux géants technologiques étrangers.

🔗Les risques d’une dépendance aux acteurs étrangers

Lorsque nous utilisons une IA développée et hébergée à l’étranger, nous confions nos données, nos requêtes, parfois même nos secrets professionnels, à des entreprises soumises à des lois qui ne sont pas celles de l’Europe.

Par exemple, une organisation française qui utilise une solution américaine peut voir ses données accessibles par le gouvernement des États-Unis, en vertu du Cloud Act, une législation qui autorise les autorités américaines à réclamer des données stockées par des entreprises américaines, même si ces données sont physiquement localisées hors du territoire américain.

Si l’acteur étranger décide unilatéralement de modifier ses conditions d’utilisation, d’augmenter drastiquement ses tarifs ou de restreindre l’accès à certains services jugés sensibles, l’utilisateur européen n’a aucun moyen d’agir, aucun levier de négociation. En cas de conflit diplomatique, de tensions géopolitiques ou de changement brutal de politique, l’accès aux outils peut même être coupé du jour au lendemain, paralysant des services essentiels. Ce manque de contrôle expose les organisations à des risques juridiques, économiques et stratégiques considérables.

🟦Les alternatives européennes : une réponse concrète

Face à ces enjeux, l’Europe développe activement ses propres solutions d’intelligence artificielle souveraines. Des entreprises comme Mistral AI, LightOn, Aleph Alpha ou encore le projet BLOOM portent cette ambition d’indépendance technologique. Ces alternatives permettent d’héberger les données localement, sur le territoire européen, de respecter scrupuleusement les réglementations européennes comme le RGPD, et d’offrir une transparence accrue sur l’utilisation des informations collectées.

Par exemple, une collectivité territoriale qui choisit une IA souveraine peut garantir à ses citoyens que leurs données ne quitteront jamais le territoire national (à condition que l’intégralité de l’hébergement et des traitements soient maîtrisés), renforçant ainsi la confiance et la sécurité. De plus, ces solutions favorisent l’innovation locale, la création d’emplois qualifiés en Europe et répondent aux besoins spécifiques des utilisateurs européens, tant sur le plan linguistique que culturel ou réglementaire.

🤝Faire des choix responsables : un enjeu pour tous !

Chacun d’entre nous, que l’on soit citoyen, salarié, chef d’entreprise ou décideur public, a un rôle à jouer dans la construction d’un avenir numérique responsable et souverain. Il est important de s’informer sur l’origine des outils d’IA que nous utilisons quotidiennement, de privilégier activement les solutions européennes lorsqu’elles existent, et de demander systématiquement des garanties claires sur l’hébergement et la gestion des données. En soutenant l’innovation locale, nous contribuons collectivement à la compétitivité de notre territoire et à la protection de nos valeurs démocratiques fondamentales.

4. Les enjeux environnementaux

⚡️Une consommation électrique croissante

Au-delà des questions de sécurité et d’éthique, l’IA générative soulève également des préoccupations environnementales majeures, souvent invisibles pour l’utilisateur final. Selon un avis récent sur la consommation énergétique liée à l’utilisation du numérique publié par l’Agence de la transition écologique (ADEME), l’empreinte carbone du numérique en France représente déjà 4,4% de l’empreinte nationale totale, soit 29,5 millions de tonnes d’équivalent CO₂, et 11% de la consommation électrique du pays.

La majorité de cet impact provient des équipements eux-mêmes : ordinateurs, smartphones, téléviseurs, serveurs. Leur fabrication concentre à elle seule 60% de l’empreinte carbone du secteur. Cette production dépend fortement de certains métaux critiques, principalement extraits en Chine, ce qui soulève également des questions cruciales de souveraineté et de sécurité d’approvisionnement. Les projections sont alarmantes : sans mesures correctrices ambitieuses, l’impact environnemental du numérique pourrait tripler d’ici 2050, mettant sérieusement en péril les objectifs nationaux et européens de décarbonation.

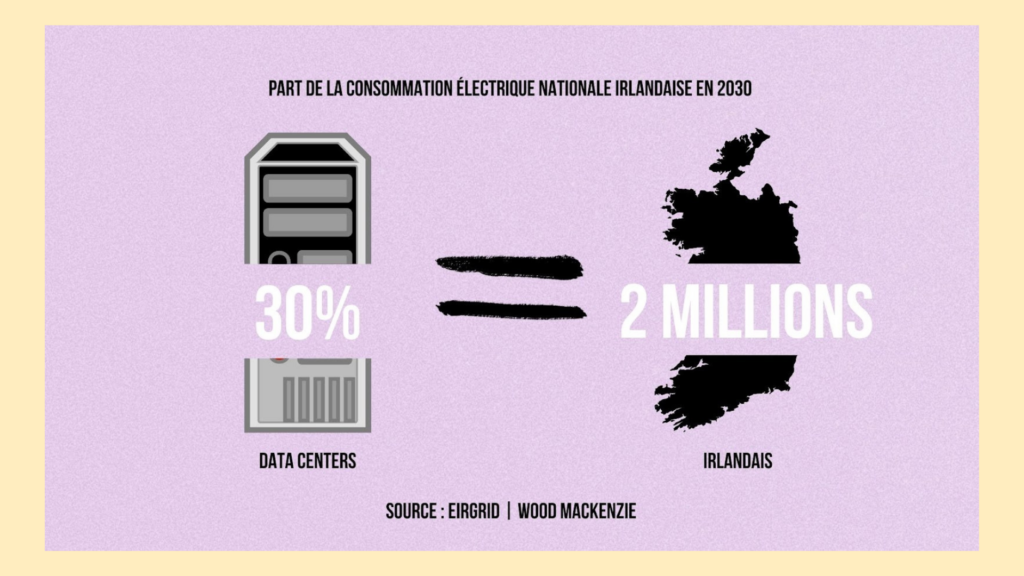

L’essor de l’intelligence artificielle s’accompagne d’un coût énergétique véritablement colossal. En 2024, les centres de données (data centers) dédiés à l’IA ont consommé environ 415 térawattheures (TWh) d’électricité, soit 1,5% de la demande mondiale. Selon l’Agence internationale de l’énergie, cette part pourrait plus que doubler d’ici 2030 pour atteindre 945 TWh, l’équivalent de la consommation électrique annuelle du Japon. Cette croissance, estimée à +15% par an, est quatre fois plus rapide que celle des autres secteurs économiques, ce qui pose un défi majeur pour la sécurité énergétique mondiale et la transition vers une économie bas carbone.Localement, l’impact est encore plus spectaculaire : en Irlande, les datacenters absorbent déjà un cinquième de la consommation nationale d’électricité. En 2025, le pays en hébergeait plus de 80.

Le cas de la consommation électrique croissante de l’Irlande

🌎️Quel est le coût écologique réel de l’IA ?

Si l’enjeu est réel, il convient cependant de noter que les différentes études évoquant les quantités de CO₂ produites lors de l’entraînement de modèles sont estimatives et varient selon la région et le mix énergétique. Aussi, le coût énergétique d’une requête sur ChatGPT varie grandement selon sa complexité. Difficile donc d’établir un comparatif énergétique clair entre une requête sur un LLM et une recherche Google. Dans ce contexte, un enjeu central de conception des modèles est précisément de réduire la consommation énergétique pour un niveau de performance donné : en optimisant les poids entre les neurones artificiels, en compressant les modèles ou en les rendant plus efficaces, certains acteurs cherchent à obtenir des résultats comparables avec beaucoup moins de ressources, comme cela a été mis en avant lors de la sortie de certains modèles récents. Il peut même y avoir, dans certains cas d’usage, un arbitrage explicite consistant à tolérer un peu plus d’erreurs en échange d’une diminution significative de la consommation d’énergie.

Cela dit, les grands acteurs du numérique (les GAFAM) constatent déjà une augmentation significative de leurs émissions de gaz à effet de serre directement liée à ces nouveaux usages. Google a annoncé son intention de remettre en service d’ici 2029 une centrale nucléaire fermée depuis cinq ans pour répondre aux besoins immédiats de ses data centers. Google n’est pas le seul : de nombreuses entreprises technologiques cherchent activement à développer des petits réacteurs modulaires (SMR, Small Modular Reactors) pour répondre à cette demande énergétique explosive. Par ailleurs, l’IA générative accélère le renouvellement des équipements, avec l’apparition d’ordinateurs et de smartphones dits “IA ready”, optimisés pour faire tourner des modèles localement, ce qui accentue encore l’impact environnemental global du secteur.

🔋Vers une “IA frugale” ?

Face à ce constat, l’ADEME insiste sur la nécessité impérieuse de développer une IA “frugale”, c’est-à-dire plus sobre en ressources et en énergie. Elle encourage le développement de petits modèles spécialisés, beaucoup moins gourmands que les grands modèles généralistes, ce qui présente des avantages non seulement environnementaux, mais aussi économiques et de souveraineté. Un référentiel général pour l’IA frugale a d’ailleurs été élaboré en France afin de proposer une méthode standardisée d’évaluation de l’impact environnemental de l’IA et de recenser les bonnes pratiques pour le réduire concrètement.

5. Les risques humains

Comme vous l’avez vu précédemment, l’absence de contrôle humain sur les résultats produits par l’IA générative constitue aujourd’hui un risque humain majeur, unanimement reconnu par l’ensemble des référentiels de cybersécurité. Ce risque s’exprime à plusieurs niveaux, tant sur le plan technique que organisationnel, et touche directement la fiabilité, la sécurité et la confiance dans les systèmes d’IA utilisés par les organisations, avec un impact potentiellement fort sur leur image et leur crédibilité.

👁️Le rôle essentiel du jugement humain

Lorsque l’IA générative est utilisée sans supervision humaine appropriée, il existe un risque majeur de délégation aveugle de tâches ou de décisions à la machine. Les utilisateurs, par manque de formation, par excès de confiance ou simplement par commodité, peuvent accorder une crédibilité injustifiée aux réponses produites par l’IA, sans procéder à une vérification critique rigoureuse.

Cette dépendance progressive peut conduire à des décisions erronées, à la diffusion d’informations inexactes ou trompeuses, voire à des actions dangereuses si l’IA est intégrée à des processus automatisés sensibles : validation de transactions financières, génération de contenus publics diffusés largement, administration de systèmes critiques, ou encore aide à la décision médicale.

L’ANSSI insiste particulièrement sur ce point dans ses recommandations : il est impératif d’intégrer systématiquement une validation humaine pour toute action ou décision à impact critique, afin de réduire significativement ce risque. L’humain doit rester le décideur final, l’IA n’étant qu’un outil d’aide à la décision.

◼️Les dangers des IA “boîtes noires”

Les modèles d’IA générative, en particulier les grands modèles de langage (LLM), fonctionnent souvent comme des “boîtes noires” opaques, ce qui complique considérablement l’identification des causes profondes d’une erreur, d’un biais ou d’un comportement inattendu. Cette opacité rend également plus complexe l’investigation en cas d’incident de sécurité ou de dérive du système, et peut empêcher la détection rapide de manipulations malveillantes, comme les attaques par injection de prompt ou l’empoisonnement de données évoquées précédemment.

Les impacts de ce risque sont multiples et profonds. Sur le plan humain, il peut entraîner une perte progressive de compétences et d’esprit critique chez les utilisateurs, qui deviennent dépendants de l’IA et moins aptes à détecter ou corriger ses erreurs. Cette dépendance peut conduire à une véritable atrophie des capacités de réflexion autonome et de jugement critique.

Sur le plan organisationnel, des décisions erronées basées sur des résultats d’IA non vérifiés, ou des incidents graves liés à un manque de supervision, peuvent conduire à des pertes financières importantes, à des sanctions réglementaires lourdes, notamment en cas de violation du RGPD ou du règlement européen sur l’IA (IA Act), et à une perte de confiance durable de la part des clients, partenaires ou du grand public.

Enfin, sur le plan réputationnel, une mauvaise gestion des résultats de l’IA, des erreurs publiques ou des scandales liés à des contenus générés sans contrôle peuvent provoquer des crises médiatiques majeures et ternir durablement l’image de l’organisation, avec des conséquences parfois irréversibles.

6. Les risques informationnels

Comme vu précédemment dans ce module, les modèles de langage génératifs produisent des textes fluides et convaincants, mais ils restent fondamentalement probabilistes : ils « devinent » la suite la plus vraisemblable d’une phrase sans vérifier systématiquement la véracité des faits avancés. Cette logique de fonctionnement entraîne deux risques majeurs sur l’information : les erreurs factuelles, et les hallucinations. Dans un contexte professionnel ou médiatique, ces dérives peuvent conduire à diffuser de fausses informations avec un vernis de crédibilité technique, rendant leur détection d’autant plus difficile.

🟨Les erreurs factuelles

Les erreurs factuelles peuvent prendre de multiples formes : dates inexactes, chiffres approximatifs, références juridiques erronées, citations attribuées à la mauvaise source, ou encore confusion entre deux événements ou deux personnes portant des noms similaires. Là où un moteur de recherche renvoie vers des documents à vérifier, un LLM fournit une réponse rédigée qui donne l’illusion d’un savoir stabilisé. Plus l’interface est fluide, plus le risque de « délégation intellectuelle » augmente : l’utilisateur tend à faire confiance au style plutôt qu’à la substance.

🟥Les hallucinations

Les hallucinations représentent un niveau de risque encore supérieur, car le modèle ne se contente pas d’approximer un fait, il en fabrique un de toutes pièces. Il peut ainsi inventer des études scientifiques inexistantes, des arrêts de jurisprudence fictifs, des normes techniques jamais publiées, des citations plausibles mais fictives, en les insérant dans un récit cohérent. Dans le domaine de la sécurité ou de la cybersécurité, un LLM peut proposer de « bonnes pratiques » totalement inefficaces, voire contre‑productives, en donnant le sentiment de maîtriser le sujet. En communication ou en éducation, ces contenus inventés risquent d’alimenter la désinformation, en se mêlant à des éléments exacts dans un ensemble difficile à démêler pour un non‑spécialiste.

✅️L’importance de la vérification

Pour limiter ces dérives, il convient de considérer par défaut toute réponse générée comme une hypothèse à vérifier, et non comme un fait établi : cela implique de systématiser la relecture humaine, le croisement des informations avec des sources fiables et, lorsque c’est possible, l’exigence de références vérifiables.

Petit test ludique pour mettre en perspective les erreurs de l’IA générative ? Faites un tour sur AI World Clocks.

Ce site génère toutes les minutes neuf horloges, chacune basée sur un modèle d’IA différent avec un objectif simple, donner l’heure exacte. Au-delà des défauts de design, on vous laisse compter le nombre d’horloges délivrant la bonne information !

Image comparant les horloges générées par différents modèles de ChatGPT

Des horloges «parfaitement fonctionnelles» selon les différents modèles de Chat-GPT.

7. Les risques liés à la vie privée

🪪L’utilisation des données personnelles

Aujourd’hui, les réseaux sociaux et les plateformes d’intelligence artificielle collectent une quantité croissante, et souvent sous-estimée, de données personnelles. Chaque publication, commentaire, interaction, “like” ou partage sur Facebook, Instagram, LinkedIn, X (anciennement Twitter) ou encore les échanges avec Gemini (Google) peuvent potentiellement être utilisés pour entraîner des modèles d’IA. Cela signifie concrètement que vos photos, vos textes, vos préférences personnelles et même vos conversations peuvent servir à améliorer les performances de ces outils commerciaux, souvent sans consentement explicite de votre part, ou avec un consentement obtenu de manière peu transparente.

Cette pratique, appelée “réutilisation des données à des fins d’entraînement”, est devenue courante dans l’industrie technologique, mais elle soulève des questions majeures sur le respect de la vie privée, le droit à l’image, et le contrôle effectif que chacun conserve sur ses informations personnelles.

📲Le cas de Meta

Prenons un exemple concret et récent : Meta, la société mère de Facebook, Instagram et WhatsApp, a informé ses utilisateurs européens que leurs publications publiques, leurs commentaires et leurs légendes de photos seraient utilisés pour entraîner ses intelligences artificielles à partir du 27 mai 2025. Les messages privés échangés sur WhatsApp, protégés par le chiffrement de bout en bout, ne sont pas concernés par cette collecte. En revanche, tout ce qui est publié en mode public peut être aspiré par les algorithmes et intégré aux données d’entraînement.

LinkedIn, de son côté, utilise également les contenus publiés et les profils professionnels de ses membres pour améliorer ses modèles d’IA, sans demander de consentement préalable explicite, en invoquant juridiquement “l’intérêt légitime” de l’entreprise, une notion du RGPD qui permet certains traitements de données sans consentement dans des cas spécifiques.

⚠️Quelles sont les conséquences ?

Lorsque vos données sont utilisées pour entraîner des IA, elles peuvent être mémorisées, analysées, recombinées et parfois réutilisées dans des contextes totalement inattendus. Par exemple, une IA conversationnelle pourrait théoriquement restituer à un autre utilisateur des informations sensibles qu’elle a “apprises” lors d’une précédente interaction avec vous, révélant ainsi involontairement des éléments de votre vie privée.

De plus, la collecte excessive de données peut conduire à la création de profils détaillés et extrêmement précis, utilisés à des fins de ciblage marketing agressif ou de prise de décisions automatisées, parfois de manière intrusive, discriminatoire ou contraire à vos intérêts. Il est donc essentiel de rester vigilant et de comprendre que, même si l’utilisation officielle de ces données vise à “améliorer les services”, elle peut aussi exposer à des risques réels de fuite d’informations, de perte de contrôle sur sa vie privée ou d’usages détournés.

⛔️Comment s’opposer concrètement à la réutilisation de ses données personnelles ?

Heureusement, il existe des moyens concrets et accessibles pour agir et mieux protéger ses données. La CNIL propose un guide pratique détaillé pour s’opposer à la réutilisation de ses données personnelles par les principales plateformes d’IA et de réseaux sociaux.

Sur Facebook et Instagram, il est possible de refuser explicitement l’utilisation de ses informations en se rendant dans le centre de confidentialité de votre compte et en remplissant un formulaire d’opposition dédié. Cette démarche peut être réalisée pour chaque compte individuellement, et une confirmation est normalement envoyée par e-mail une fois que votre demande de retrait du consentement a été prise en compte.

Sur LinkedIn, il suffit de désactiver une option spécifique dans les paramètres de votre compte, en naviguant vers “Préférences et confidentialité”, puis en désactivant l’option “Données pour l’amélioration de l’IA générative”.

Pour Google Gemini, il faut accéder à l’onglet “Activité” de votre compte Google et désactiver l’option “Activité dans les applications Gemini”. Attention cependant : cette désactivation peut entraîner la suppression complète de l’historique de vos conversations avec l’outil.

La CNIL rappelle fermement que le droit d’opposition est un droit fondamental garanti par le Règlement Général sur la Protection des Données (RGPD). Vous pouvez à tout moment demander à une entreprise de ne plus utiliser vos données pour un objectif précis, et si vous rencontrez des difficultés ou des refus injustifiés, vous avez la possibilité de saisir directement la CNIL pour faire valoir vos droits.

🦾Adopter une démarche responsable et proactive

Pour protéger efficacement votre vie privée dans ce nouvel écosystème numérique, il est important de prendre l’habitude de vérifier régulièrement les paramètres de confidentialité de vos comptes sur les réseaux sociaux et les plateformes d’IA que vous utilisez. N’hésitez jamais à exercer votre droit d’opposition, à demander des explications claires et transparentes sur l’utilisation concrète de vos données, et à sensibiliser votre entourage, vos collègues et vos proches à ces enjeux encore trop méconnus. En agissant ainsi individuellement et collectivement, vous contribuez activement à un usage plus éthique et respectueux de l’intelligence artificielle, mais également du numérique dans son ensemble.

Pour aller plus loin sur ce sujet crucial, vous pouvez consulter le guide détaillé de la CNIL : “IA et vie privée : comment s’opposer à la réutilisation de ses données personnelles pour l’entraînement d’agents conversationnels ?”

Petite pause dans ce flux d’informations. Voici un rapide quizz pour revenir sur quelques notions abordées au fil de ces derniers paragraphes :

Quizz

Pourquoi l’ANSSI recommande-t-elle de ne jamais saisir de données sensibles dans une IA générative non maîtrisée ?

Qu’est-ce que le « jailbreaking » dans le contexte des IA ?

Quel est le risque principal lié à l’utilisation de modèles d’IA hébergés à l’étranger, selon le texte ?

Selon le texte, quel paradoxe écologique est soulevé par l’essor de l’IA générative ?

Ce module a été rédigé par Hugo Lausenaz-Pire, consultant en gestion des risques et conformité de cybersécurité chez Advens, passionné par l'intelligence artificielle et diplômé en Mastère expert informatique et système d'information spécialité sécurité IT.